Ce înseamnă crawl budget și cum se poate optimiza?

Cuprins

- Ce reprezintă Crawl Budget-ul?

- Cum putem verifica ce Crawl Budget ne este alocat?

- Cum poți convinge Google să îți viziteze mai des paginile?

- În concluzie – putem să optimizăm Crawl Budget-ul pentru un website?

- 6 sfaturi pentru optimizarea și creșterea crawl budget-ului

- Pe scurt – concluzii legate de crawl budget

Există multe lucruri pe care le puteți face la nivel de optimizare pentru a atinge acest obiectiv: keyword research solid, creare de conținut bun, utilizare link-uri externe și interne, un profil bun de backlinks ș.a.m.d. Despre ce se vorbește însă mult prea puțin este modul în care Google ne vizitează site-ul. Contează? Da, contează enorm, pentru ca în funcție de aceasta se face și analiza paginilor, stabilirea "autorității interne" a fiecărei pagini, iar de toate acestea depind indexarea și poziționarea acestora.

Conceptul din spatele crawl budget-ului este foarte tehnic, așa că vom încerca să-l explicăm într-un mod simplu și să vă sugerăm apoi moduri în care îl puteți optimiza.

Ce reprezintă Crawl Budget-ul?

Înainte de a începe, trebuie să explicăm pe scurt trei termeni cheie, folosiți destul de des ca sinonime, dar care au de fapt sensuri diferite: scanarea, indexarea și poziționarea.

Ce se înțelege prin aceste cuvinte?

- Mai întâi de toate, Googlebot scanează pagina. Aceasta poate fi o pagină nouă cu conținut nou, o pagină existentă cu conținut actualizat.. sau o pagină existentă cu conținut existent.

- În urma scanării, pagina este indexată (sau poate fi indexată – rezultatul nu este niciodată garantat), ceea ce înseamnă că este introdusă în baza de date și poate apărea în SERPs.

- Apoi, Google decide unde să poziționeze (sau să clasifice) pagina ca răspuns la căutările utilizatorilor (pagina în sine nu are nicio poziție – ci i se acordă poziții relativ la fiecare termen de căutare pentru care este luată în considerare).

Un crawl budget este pur și simplu modul în care Google decide să investească în scanarea paginilor unui site web, și implicit în indexarea acestora.

Googlebot – crawlerul Google, este responsabil pentru scanarea fiecărei pagini disponibile de pe internet. Raportat la un website, Googlebot face una sau chiar mai multe vizite pe zi, în care vizitează o parte din pagini, sau pe toate – asta depinzând de foarte mulți factori.

În principiu, Googlebot vizitează cât mai multe URL-uri posibil într-un site, deoarece Google este "flămând" după conținut. Scopul scanărilor este de a fi la curent cu noul conținut de pe web și de a oferi utilizatorilor un răspuns mereu relevant și fresh la interogările lor.

Din păcate pentru noi însă, resursele pe care Googlebot le alocă unui website nu sunt nelimitate, dar nici dependente de numărul de pagini ale acestuia – cât mai ales de calitatea acestora și de ușurința navigării între ele. De aceea, optimizarea crawl budget-ului este foarte importantă. Cu cât paginile sunt mai bune și mai accesibile, cu atât sunt mai ușor de citit și cu atât googlebot investește mai mult timp pentru a le citi.

Întrebările pe care le-am adunat în această introducere, în rezumat, sunt:

Cum putem verifica ce Crawl Budget ne este alocat?

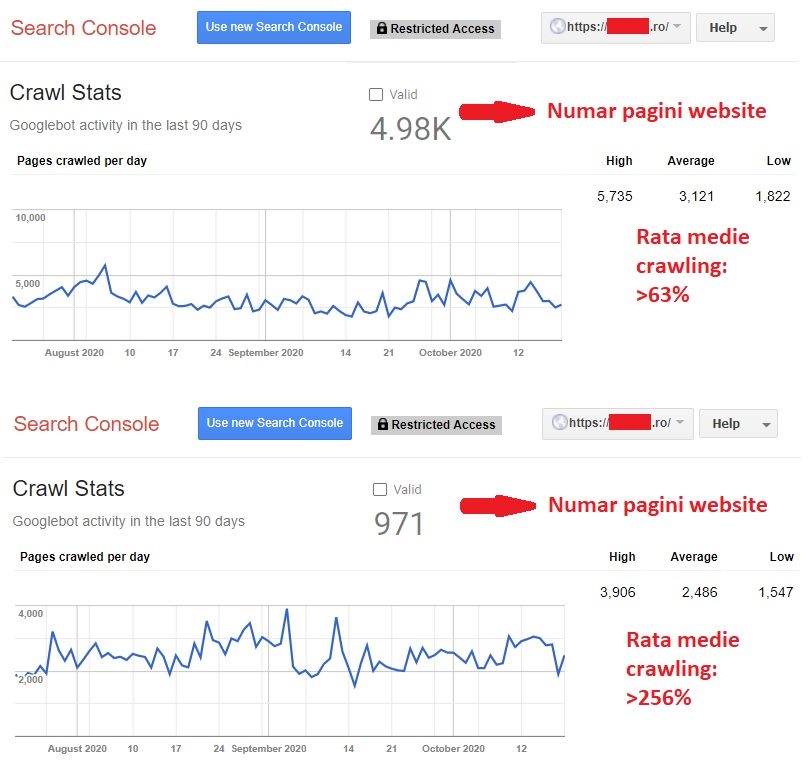

Aici răspundem la întrebarea "Cât timp petrece Googlebot pe paginile mele?".

Pentru a urmări activitatea Googlebot, un instrument util și gratuit este Google Search Console. Acest instrument vă permite să aflați cum vă vizitează Googlebot – în special câte pagini vizitează zilnic. Este de ajuns să comparați apoi cu numărul de pagini al site-ului, și aveți o bună idee asupra ce este văzut și ce nu.

Descoperirea activității Googlebot în ultimele 90 de zile este ușoară:

- Accesați Google Search Console.

- Faceți clic pe "Legacy tools and reports" ("Instrumente și rapoarte vechi")

- Faceți clic pe "Crawl stats" ("Statistici accesare cu crawlere")

Se vor afișa trei grafice, fiecare cu câte trei valori (High, Average și Low). Primul grafic afișează paginile scanate pe zi de Googlebot, al doilea afișează cantitatea în kilobytes descărcată zilnic, iar al treilea arată timpul petrecut descărcând o pagină.

Pentru primul grafic, este clar – cu cât valorile sunt mai mari, cu atât mai bine. Pentru al doilea și al treilea grafic, opusul este varianta corectă.

Toate informațiile de aici conduc spre posibilitatea tragerii unor concluzii:

- Dacă paginile sunt prea mari (ca dimensiune în kilobytes), numărul de pagini vizitate zilnic va fi mai mic.

- Dacă timpul necesar descărcării unei pagini este ridicat – la fel.

Iar ce căutăm de fapt, este sa ne asigurăm ca Googlebot ne vizitează toate paginile – dacă se poate chiar de mai multe ori pe zi. Iar această afirmație logică ne conduce către următoarea parte a articolului.

Cum poți convinge Google să îți viziteze mai des paginile?

Dacă ați observat că crawl budget-ul nu este foarte mare, nu trebuie să intrați în panică – sunt multe lucruri pe care le puteți face.

Abordarea clasică – provenită în mare măsură din guideline-urile și comunicările Google, ne îndeamnă spre îmbunătățirea site-ului:

- Creați conținut de înaltă calitate și mai ales – în mod regulat.

- Actualizați pe cât posibil și conținutul vechi, de asemenea în mod regulat.

- Conținutul ar trebui să varieze, ceea ce înseamnă că nu numai textul ar trebui să domine pagina, aceasta ar trebui să includă, de asemenea, imagini, videoclipuri, PDF-uri etc.

- Asigurați-vă că organizarea sitemap-ului (ne referim mai ales la cel XML – dar nici cel HTML nu strică deloc) este clară și poate fi citită de către Google, mai ales dacă rulați un site mare. Nu uitați să sincronizați sitemap XML în Google Search Console.

- Utilizați linkuri interne pe toate paginile. În caz contrar, Googlebot ar putea ajunge într-o "fundătură", dacă există pagini care nu au nici un link intern în ele. Aici nu includem link-urile navigaționale – importante și ele, dar urmărirea lor până la următoarea pagină presupune mereu descărcarea a încă 1, 2, 3 etc pagini, ceea ce, desigur, consumă din mult prea prețiosul crawl budget.

- Nu uitați de backlinks – cu cât un site are mai multă autoritate, cu atât are șanse să fie "tratat" cu mai multe resurse alocate. Chiar și potrivit Google, "Cele mai populare URL-uri de pe Internet tind să fie scanate mai des ... ". Oricâte controverse am deschide pe tema a ce înțelege Google prin "popularitate", sigur tot la backlinks ajungem ca răspuns.

În concluzie – putem să optimizăm Crawl Budget-ul pentru un website?

Dacă ați urmat sfaturile de mai sus și ați reușit să captați atenția Google, este timpul să vă concentrați pe abordare mai apropiată de SEO-ul clasic. "Optimizarea" în acest sens înseamnă maximizarea timpului pe care Googlebot îl dedică paginilor voastre.

Dacă aveți pagini pe site care nu au valoare adăugată pentru utilizatori sau care prezintă conținut duplicat, riscați ca Googlebot să piardă timp prețios. Acesta este, desigur, ceva ce trebuie evitat.

Rețineți întotdeauna că:

- Un site web popular cu conținut recent sau actualizat va beneficia de un crawl budget mai mare.

- În schimb, dublurile, paginile cu calitatea scăzută a conținutului, conținutul care nu mai este actualizat, redirecturile și link-urile cu eroare 404 nu numai că vor consuma inutil o mare parte din crawl budget, dar vor conduce și spre reducerea acestuia.

Așadar, deși poate părea evident, crearea de conținut de calitate scăzută este contraproductivă și din alte motive decât cele la care ne gândim în mod obișnuit. Discutăm aici de riscul ca Googlebot să piardă timpul de scanare disponibil cu paginile de conținut de calitate scăzută, mai degrabă decât să îl aloce pentru a le scana pe cele de înaltă calitate, cele pe care de fapt ne bazăm în așteptările noastre de a obține trafic organic.

Trecem acum spre zona ideilor complementare legate de subiect – adică cele care nu mai sunt legate direct de nivelul calitativ al site-ului și al paginilor sale. Există două laturi ale crawl budget-ului pe care le puteți optimiza: în primul rând, puteți mări crawl budget-ul și puteți reduce timpul dintre scanări.

6 sfaturi pentru optimizarea și creșterea crawl budget-ului

1. Vă trebuie un server rapid

Viteza este esențială, deoarece timpul pe care Googlebot îl dedică paginilor nu este nelimitat – cu alte cuvinte – dacă facem ca o pagină sa fie descărcată de două ori mai repede, avem șanse serioase să ni se viziteze de două ori mai multe pagini.

Pe scurt: optimizarea timpului de descărcare al unei pagini înseamnă a oferi Googlebot mai mult timp de petrecut pe alte pagini. Iată câteva sfaturi pe care le puteți lua în considerare:

- Investiți într-un server de calitate

- Optimizați codul sursă pentru a-l face mai "lizibil" pentru Googlebot

- Comprimați imaginile fără a fi nevoie să sacrificați calitatea. Tinypng este un exemplu de site gratuit care reduce dimensiunile fișierelor de imagini.

- Reduceți la maxim numărul și cantitatea resurselor externe utilizate de către pagini.

- Renunțați măcar la o parte din elementele vizuale care nu aduc un plus semnificativ de informație și de utilitate pentru vizitatori.

2. Optimizați structura site-ului

O structură clară și liniară a paginilor de pe site vă permite să profitați la maxim de crawl budget: Googlebot poate scana și indexa cu ușurință mai multe pagini.

Fiți atenți la următoarele puncte:

- Urmați celebra regulă cu trei clickuri, care afirmă că un utilizator ar trebui să poată să ajungă de la orice pagină de pe site la oricare altă pagină, cu un maxim de trei clickuri.

- Evitați paginile cu dead-end. Aceasta se referă în special la paginile care nu au legături interne – altele decât cele din meniu / footer.

- Utilizați rel canonical. Chiar dacă nu ajută direct la creșterea crawl budget-ului, permite Google să înțeleagă ce versiune a paginii ar trebui să ia în considerare la scanarea și indexarea diferitelor versiuni.

3. Utilizați linkurile interne

Link-uri interne, care servesc practic pentru a adăuga adâncime pe un anumit subiect, ar trebui să se îndrepte cu preponderență către paginile pe care doriți ca Googlebot să le ia în considerare mai mult decât pe altele.

Dacă indicați paginile preferate, aveți o șansă mai mare ca crawlerul să ajungă să le scaneze. Google se concentrează oricum mai mult pe paginile care conțin o mulțime de linkuri, atât interne, cât și externe – fără a exagera însă (regula veche cu maxim 100 de link-uri active într-o pagină, deși neconfirmată, rămâne încă un etalon de best practice).

4. Făra broken links

Link-uri cu eroare la destinație (broken links – link-uri încheiate cu eroare 404) reprezintă o risipă mare de crawl budget. În mare măsură această afirmație este valabilă și pentru link-urile încheiate cu redirect (301 sau 302).

5. Utilizați links cu rel nofollow doar acolo unde este clar necesar

În principiu, link-urile cu nofollow vor salva resurse importante din crawl budget, împiedicând Googlebot să piardă timp cu scanarea paginilor care nu contează pentru rankings.

Totuși, aici nivelul de controversă în rândul specialiștilor SEO este deosebit de ridicat. În primul rând, nofollow pe un link nu mai înseamnă ca Googlebot nu îl va urma. Apoi, nofollow în structura internă este posibil să transmită și alt tip de mesaj – greu de estimat natura și implicațiile acestuia.

Din aceste motive, o abordare mult mai sigură este blocarea completă a accesului la paginile pe care nu le dorim vizitate și indexate. Referindu-ne de pildă la site-uri de ecommerce, avem tot interesul să oprim Googlegot din a vizita sumedenia de pagini utile vizitatorului, dar absolut inutile pentru rankings (zonele de orders, cart, filtrele, variantele etc). De pildă, chiar dacă avem N variante pentru o pagină, definite cu rel canonical în mod corect, Googlebot tot va trebui să le descarce pentru a citi adresa canonică. Reducând accesul la ele din start însă, înseamnă economie de crawl budget.

Cum putem face asta – cu robots.txt. Robots.txt, un fișier text simplu, este util pentru blocarea paginilor la care ne refeream mai sus.

Robot.txt este fundamental dacă doriți să evitați irosirea timpului crawlerului cu acele pagini care nu trebuie scanate. Acestea ar putea fi chiar și pagini private sau pagini de administrare.

6. Ștergeți conținutul inutil / duplicat

Eliminarea tuturor paginilor care nu mai sunt relevante sau care nu au mult trafic vă va împiedica să pierdeți crawl budget-ul. Dacă nu doriți să pierdeți complet anumite părți din conținutul acestor pagini, le puteți muta în pagini similare sau complementare, vechi sau noi.

Atenție însă la asemenea mutări de conținut, mai ales atunci când pagina la care renunțați mai are câteva vizite organice, sau dacă există backlinks către ea – este necesar să implementați un redirect 301 către noua pagină. În același timp însă – editați site-ul astfel încât să nu mai rămână link-uri interne către paginile dispărute sau mutate (rolul redirectului 301 nu este de a ne scăpa de acest demers).

Pe scurt – concluzii legate de crawl budget

Primul lucru pe care trebuie să îl spunem: crawl budget-ul este unul dintre cele mai ignorate elemente ale SEO, asta în timp ce importanța sa reală este extrem de mare.

Al doilea aspect: chiar dacă și pentru site-urile de mici dimensiuni este important, pentru cele de mari dimensiuni crawl budget-ul este absolut esențial.

Și ultimul, deși am mai putea vorbi multă vreme pe acest subiect: optimizarea crawl budget-ului nu este o ramură aparte a SEO, și nu introduce tehnici noi, dar pe multe dintre acestea le pune într-o cu totul altă lumină, modificându-le substanțial importanța.